Effizienz steht auf der IT-to-do-Liste über allem,

gleich darunter steht Kosten sparen. Für IT-Leiter ist dies aber nur mit

einem flexiblen und modularen Storage-Management zu erreichen. Nur mit

einer modernen Verwaltung lassen sich die heutigen Aufgaben meistern.

Transparente Tools ersetzen starre Strukturen.

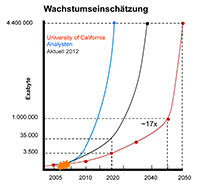

Die

unternehmensweite Datenspeicherung wird von diversen Faktoren

beeinflusst. Die wachsende Datenmenge ist aber sicherlich einer der

Hauptgründe, seine Speicherstrategie zu überdenken.

IDC zufolge wurden letztes Jahr weltweit

zirka 1,8 ZByte erzeugt und kopiert.

2009 waren es noch lediglich 0,8 ZByte. Analystenzahlen klingen immer

so ein wenig nach Zukunftsmusik und sind wenig greifbar. Doch vor drei

Jahren begann der Wechsel von 1- auf 2-TByte-Festplatten. Ein 2U flaches

8-Bay-Array unterstützte damals eine Bruttokapazität von bis zu 16

TByte. Heute wird ein entsprechendes System mit 3-TByte-Disks und einem

Speichervolumen von 24 TByte geliefert.

»Ein kleines Video

für eine Produkteinführung beansprucht, in ein paar Versionen

gespeichert, schnell mal so viel Platz wie früher die Daten von 100.000

Kunden«, erklärt André M. Braun, Germany Sales Director Storage bei Dell.

»Noch hält die stete Weiterentwicklung der herkömmlichen

Speichertechnologien mit den Anforderungen einigermaßen Schritt. Aber

die Unternehmen versuchen, die Datenflut mit Mitteln im Griff zu halten,

die dafür nun mal nicht geschaffen wurden, und die für diese Aufgabe

auf Dauer auch nicht tauglich sind. Es sollen mit Technologien von

gestern, mit monolithischen und starren Infrastrukturen, die Aufgaben

von morgen bewältigt werden. Das kann nicht gutgehen.«

»Bestehende monolithische Systeme müssen nicht zwangsläufig sofort auf das Abstellgleis geschoben werden«, schränkt Dr. Georgios Rimikis, Manager Solutions Strategy bei Hitachi Data Systems

(HDS), ein. »Wir sehen derzeit viele Projekte, die monolithische

Systeme mit neu beschafften modularen Systemen integrieren. Aktuelle

Designs gehen jedoch genau diesen Weg: flexibel und skalierbar, und

damit zukunftssicher – und nicht zuletzt kostengünstiger.«

Mehr

Daten bedeutet laut Rimikis vor allem: »auf die Kostenbremse zu

treten«. Die Kapitalkosten lassen sich durch eine bessere Ausnutzung der

Infrastruktur senken, wie mit dynamischem Tiering, Dynamic-Provisioning

und vor allem Virtualisierung. Auf Seite der Betriebskosten erreichen

Unternehmen Einsparungen durch eine optimierte Verwaltung. Vor allem

eine fortschreitende Automatisierung sowie ein einheitliches Management

für Block-, File und Content-Daten sind hier strategische Faktoren.

Fokusthema Migration

»Der

Migrationsaufwand einer modularen, proprietären Umgebung kann

erhebliche Implikationen auf den Umgang mit Datenwachstum bedeuten«,

meint Rimikis. »Virtualisierungs-Technologien auf der Storage-Ebene

helfen hier, künftigen Zugriff auf Daten sicherzustellen. Sie

ermöglichen Technologiewechsel mit geringen Auswirkungen auf den

operativen Betrieb. Unterbrechungsfreie Migrationen sind so die Regel,

nicht die Ausnahme.« Zu beachten sei hier die Integration

objektbasierter Storage-Lösungen. Besonders unstrukturierte Datenmengen

wachsen stark in Unternehmen. Objektbasierte Storage-Lösungen verpacken

Daten mit Metadaten und sollen so Dopplungen automatisch erkennen. »Auf

diese Weise erleichtern sie nicht nur das sichere Archivieren, sondern

auch das schnelle Auffinden von Daten«, erklärt Rimikis. »Damit leisten

die Systeme einen Beitrag zur Kostensenkung.«

»Um

den jetzigen und – noch wichtiger – den kommenden Anforderungen gerecht

zu werden, müssen Migrationswege auch zukünftig einfach umsetzbar und

ohne lange Migrationsphasen und den damit verbunden Einschränkungen des

laufenden Betriebes sein«, argumentiert Robert Guzek, Eternus Business Management Germany bei Fujitsu.

»Dabei müssen Unternehmen bei einer Investition immer die Kosten für

einen Wechsel auf eine neue zukünftige Plattform mit berücksichtigen.«

Es sei zu erwarten, dass die Migrationskosten und die damit verbundenen

Anforderungen massiv zunehmen und sich höher auswirken können als das

eigentliche Hardware-Investment. Bei arbeitsintensiven Migrationen

besteht unter anderem ein erhöhtes Risiko einer Geschäftsunterbrechung.

Eine Unterbrechung des Kerngeschäftsbetriebes kann schnell sehr

kostspielig werden. »So beziffert eine Studie der PWC aus März 2012 den

Ausfall der Kernarbeitszeit (»mainly staff time«) im Mittelstand

umgerechnet mit rund 5.000 bis 9.000 Euro«, sagt Guzek. »Bei einen

Ausfall über zwei bis vier Tage erhöht sich der Betrag schnell auf über

38.000 Euro, ohne die Berücksichtigung eines eventuellen zusätzlichen

Imageschaden für das Unternehmen.«

Storage-Management: Entwicklungspotenzial in Unternehmen

Storage-Management

ist eine Pflichtaufgabe, um den »Laden am Laufen« zu halten. Der Trend

zu höherer Modularisierung, mehr Flexibilität und Zukunftssicherheit ist

nicht neu (siehe

Effizientes Storage-Management),

wird aber durch neue und steigende Anforderungen stetig neu befeuert.

Die Herstellerseite ist durchaus bemüht, ein übergreifendes Management

zu entwickeln. »Auf Anwenderseite werden diese Möglichkeiten noch nicht

umfassend genutzt«, sagt

Alfred Beblik,

Consultant im Bereich Projekt Development beim Wiesbadener Storage-Distributor

TIM. »Zum einen sind die Tools komplex in der Handhabung und zum anderen sind die Kosten ein Hinderungsgrund.«

Vor

allem kleine und mittlere Unternehmen befinden sich hier in einem

Nachteil. Zwar verfügen große Firmen über ein höheres Speichervolumina

und sind damit gezwungen größere Synergiepotenziale zu erschließen. Sie

haben aber den Vorteil, dass sie auch umfangreiche Projekte mit eigenen

Ressourcen umsetzen können. In kleineren Unternehmen ist zwar das

Fachwissen vorhanden, aber in der Regel nicht genug Ressourcen.

Eine Speicherlösung die auch in KMUs besteht, muss laut Stefan von Dreusche, Director Central Europe bei DataCore Software,

daher flexibel und vor allem einfach sein: »Bei unserer Entwicklung

galt intern: "Wer Windows administrieren kann, soll auch mit

`SANsymphony-V´ klar kommen.« Wobei der Storage-Administrator für von

Dreusche eine vermutlich aussterbende Spezies ist. Die ganze

Organisationsstruktur im Rechenzentrum ändere sich durch die

Virtualisierung von Server und Storage bzw. durch die private Cloud.

»Dem muss ein Storage-Management-Produkt Rechnung tragen«, erklärt von

Dreusche. »Automation ist natürlich das Stichwort. Auch in großen

Cloud-Umgebungen müssen manuelle Eingriffe für hunderte oder tausende

virtuelle Maschinen durch Gruppenbefehle reduziert werden. Test-,

Analyse- und Billing-Funktionen müssen integriert sein.«

Letztendlich

sind sich Enterprise-Umgebungen sowie KMUs recht ähnlich: Leistung,

Verfügbarkeit und Sicherheit sind hier wie dort wichtige Faktoren. Bei

größeren Firmen und Konzernen wird noch mehr Wert auf redundante

Datenhaltung und einen unterbrechungsfreien Betrieb Wert gelegt. Bei

allen ist zu beobachten, dass die längerfristige Strategie und das

Kosten/Nutzen-Verhalten mehr Beachtung finden als früher.

»Die

Storage-Architektur der Zukunft beginnt sich aktuell schon

abzuzeichnen«, sagt TIM-Consultant Beblik. »Es werden vermehrt

Funktionalitäten benötigt, die über die klassische Bereitstellung von

Kapazität und Verfügbarkeit hinaus gehen. Die Systeme müssen von der

Effizienz deutlich zulegen. Ein weiterer sehr wichtiger Punkt wird

zunehmend die einfache Administrierbarkeit der Systeme.« Die Überwachung

bzw. der Ausbau des Speicher-Equipments muss ohne großen Aufwand

beherrschbar sein. Nur so lassen sich die vorhandenen Ressourcen

effektiv nutzen und ein Mehrwert für das Unternehmen erzielen, egal wie

schnell das eigene Datenwachstum voranschreitet. Um sich für die Zukunft

perfekt aufzustellen, müssen Unternehmen aber den persönlichen Bedarf

genau analysieren. Hier helfen unter anderem Storage-Monitoring-Tools.

Beitrag auf Speicherguide.de lesen

DataCore Software trägt seinem weltweiten Wachstum Rechnung und

besetzt erstmals die Position eines Chief Operating Officer (COO). Steve Houck,

zuvor Vice President of Worldwide Channel bei VMware und in verschiedenen

Führungspositionen bei EMC und dem SSD-Startup Astute Networks, zeichnet ab

sofort für die Leitung, Steuerung und Organisation der Betriebsprozesse beim

Anbieter für die Storage-Hypervisor-Software SANsymphony™-V verantwortlich.

DataCore Software trägt seinem weltweiten Wachstum Rechnung und

besetzt erstmals die Position eines Chief Operating Officer (COO). Steve Houck,

zuvor Vice President of Worldwide Channel bei VMware und in verschiedenen

Führungspositionen bei EMC und dem SSD-Startup Astute Networks, zeichnet ab

sofort für die Leitung, Steuerung und Organisation der Betriebsprozesse beim

Anbieter für die Storage-Hypervisor-Software SANsymphony™-V verantwortlich.